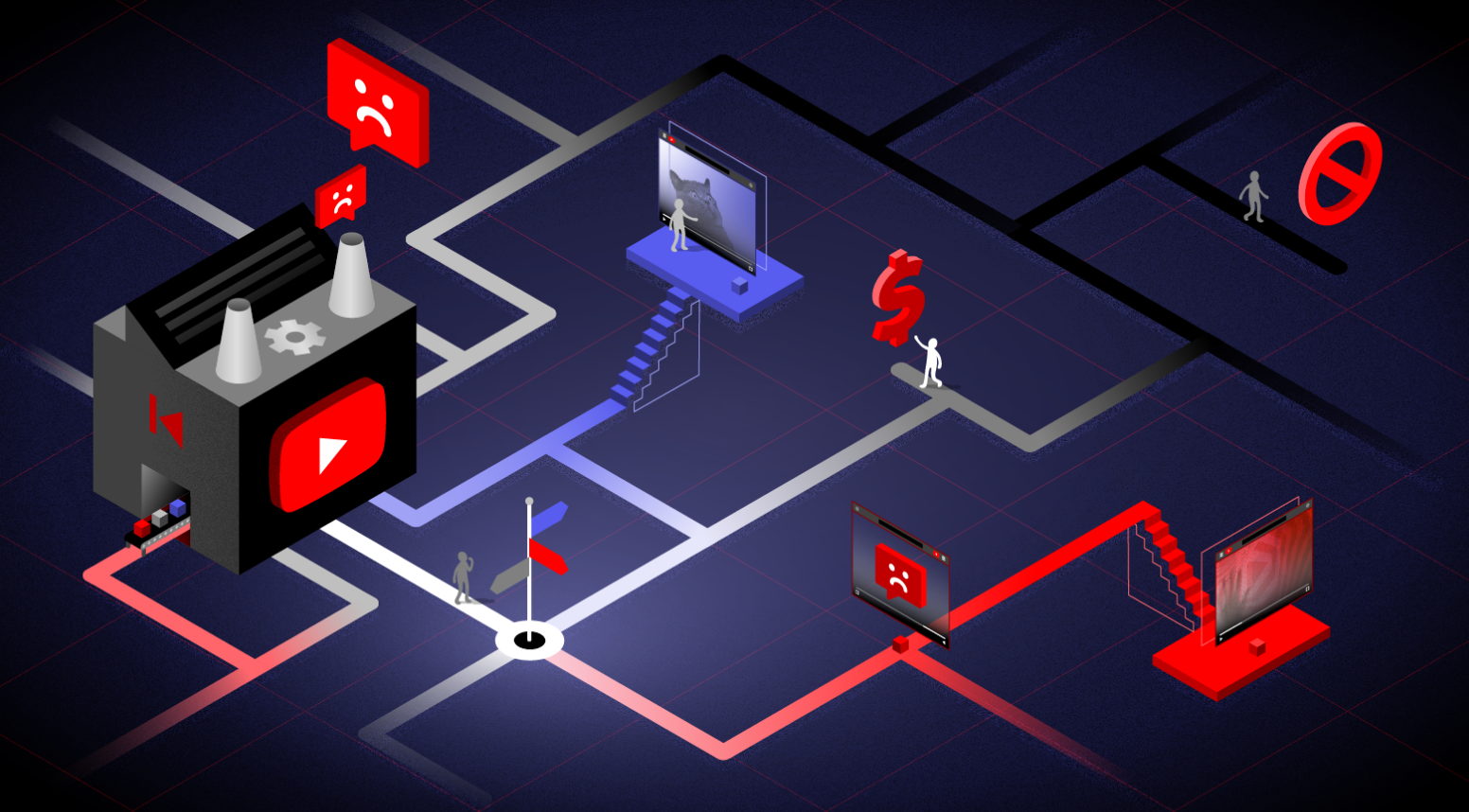

Розслідування: алгоритм YouTube сам порушує політику компанії

Алгоритми платформи YouTube рекомендують відео, які порушують власні правила платформи

Про це йдеться в розслідуванні Mozilla Foundation.

Дуже часто в рекомендації потрапляє відео, що містить насильство, шкодить психічному здоров'ю та порушує власні правила YouTube, ідеться в десятимісячному розслідуванні. Особливо часто це стається не англійською, а іншими мовами.

Тисячі користувачів добровільно надали доступ до своїх браузерів, які обробила автоматична програма. Це найбільше подібне розслідування алгоритму дотепер.

Що воно виявило?

- Користувачі стикалися в рекомендаціях із відео від теорій змови щодо Covid-19 та політичної дезінформації й до дико неналежних "дитячих" відео.

- У країнах, де головна мова не англійська, це відбувалося на 60% частіше

- 71% відео, на які скаржилися волонтери, надавав їм сам алгоритм YouTube

- Близько 200 відео, які спершу рекомендував алгоритм, потім були видалені Ютубом – але до цього вони зібрали 160 млн переглядів загалом

- Рекомендовані відео на 40% імовірніше будуть серед тих, які викличуть негативні емоції, ніж ні, які люди самі шукали.

- У 43% випадків скарг рекомендація була, на думку користувача, взагалі не пов'язана з тим, що він шукав.

Серед прикладів - багато хейтспічу (мови ненависті), запереченої політичної та наукової дезінформації. При цьому серед неангломовних користувачів значно більше "наганяння страху" та дезінформації щодо Covid-19.